<< DN 2025-10-28 | DN 2025-10-30 >>

Webサーバーアーキテクチャ進化論2023 - blog.ojisan.io

Thread by @github

Welcome to your Agent HQ 📍Orchestrate any agent, any time, anywhere.

— GitHub (@github) October 28, 2025

Coding agents from @claudeai, @OpenAI, @cognition, @julesagent, @xai and more will become available in GitHub as part of your paid Copilot subscription.https://t.co/3d8a2Cafqq pic.twitter.com/eLN8YKwxCX

Thread by @4ki4 - X (formerly Twitter)

スタートアップ資金調達ランキング(2025年9月)https://t.co/YJUDSWi08b https://t.co/Nr9P9UZaf7 pic.twitter.com/jHfOrlqKMH

— 世界四季報 (@4ki4) October 28, 2025

Thread by @tmiyatake1

アメリカではまぁまぁ成功しているSaaS企業のエグジット環境が厳しくなっている。

— Tetsuro Miyatake (@tmiyatake1) October 28, 2025

今まではPEファンドに買収されたり、いずれかは上場を狙えていたが、上場ハードルが高くなると同時に売却先がAI領域に関心を持っているため、成長プランを変えなければいけないSaaS企業が今後増える。…

Thread by @lennysan

My biggest takeaways from Dhanji Prasanna, CTO of @Blocks:

— Lenny Rachitsky (@lennysan) October 27, 2025

1. Block’s internal AI agent "Goose" is saving employees on average 8 to 10 hours per week. The company built an open-source tool called Goose that handles tasks from organizing files to writing code. Across the entire… pic.twitter.com/i431s7gore

- AI導入の効果は平均で20〜25%の手作業時間削減につながり、特にノンテック部門で効率が大きく向上しました。

- エンジニアリングよりも法務・リスク・オペレーションでの内製化が進み、週単位の作業が数時間に短縮されました。

- 事業別の縦割りをやめて機能別の一本化に再編した結果、AI以上の加速効果を生み出しました。

- プロダクト成功はコードの美しさではなく、ユーザーの課題解決にどれだけ集中できるかで決まります。

- AIにより、複数案を同時並行で試し、合わないものは躊躇なく捨てる実験スタイルが可能になりました。

- 大きな賭けではなく、小さな実験から始めて実証しながら育てることが成功率を高めます。

- 経営層がAIを日常的に使い、ワークフロー変化を体感することが全社浸透の最短ルートになります。

- レガシーな複雑なコードベースではAIの効果が出にくいため、グリーンフィールドに優先投入することが重要です。

- 価値ある技術をオープンソースとして提供することは、採用・評判・エコシステム強化に戦略的な利益をもたらします。

- 技術選定は流行ではなく企業の目的に紐づけるべきであり、Blockは「経済的エンパワーメント」を羅針盤にしています。

Thread by @gihyo_hansoku

【新刊】2025年12月5日発売『Claude CodeによるAI駆動開発入門』本体2,800円+税,平川知秀 著,Claude Codeの基本から活用方法までこの一冊でぜんぶ学べる!https://t.co/CWxwazsgqQ pic.twitter.com/ui1LkUOlX6

— 技術評論社販売促進部 (@gihyo_hansoku) October 28, 2025

Thread by @tmiyatake1

人気ポッドキャスト「Diary of a CEO」は2017年にローンチしてから1,300万人の登録者まで成長した。

— Tetsuro Miyatake (@tmiyatake1) October 28, 2025

誰よりもやり続けることと「失敗 → 学び → 改善 → 成長」のプロセスを好きであり続けられるのかが勝負ポイントとのこと。… pic.twitter.com/YZc2h1r4A5

Thread by @burkeholland

Plan mode now built into Copilot in @Code.

— Burke Holland (@burkeholland) October 28, 2025

Try this in Insiders with GPT-5. It's crazy how much better your AI experience is with just the planning mode. pic.twitter.com/TrPDJZcwOn

DeepSeek-OCR: Contexts Optical Compression | alphaXiv - arXiv

DeepSeek-OCR: Contexts Optical Compression | alphaXiv

テキストの長文処理はトークン数に対して計算量が増大するという根本課題を抱えています。本研究は、そのボトルネックを「テキストを画像に置き換えて圧縮する」発想で乗り越えようとする初期検証です。提案手法DeepSeek-OCRは、視覚エンコーダDeepEncoderとMoEデコーダ(DeepSeek-3B-MoE)からなるエンドツーエンドOCR/VLMで、視覚トークン数を徹底的に抑えつつ高精度にテキストへ復号します。Foxベンチマークでは、視覚トークンとテキストトークンの比が約1:10(圧縮10×未満)の範囲で97%の精度、20×でも約60%を達成し、画像を介した「文脈圧縮」が有望であることを実証しました。実運用面でも、OmniDocBenchで少数トークン設定のままSOTA級性能を示し、大規模データ生成の生産性も高いのが特徴です。論文とコードはhttps://arxiv.org/abs/2510.18234 および http://github.com/deepseek-ai/DeepSeek-OCR で公開されています。

Introducing Agent HQ: Any agent, any way you work - The GitHub Blog

Introducing Agent HQ: Any agent, any way you work

- 「Agent HQ」は、Anthropic・OpenAI・Google・Cognition・xAIなどのエージェントをGitHub上で並列に使い分けられるようにする構想を示し、順次Copilot有償サブスクリプション内で利用可能にしていくと発表しました。

- 中核機能「Mission control」は、GitHub/VS Code/CLI/モバイルで共通の指令塔として、複数エージェントへの割り当て・進捗監視・介入を一元的に行えるようにしました。

- 新しいブランチコントロール・エージェントのアイデンティティ管理・ワンクリックのコンフリクト解消・改善されたコメント機能・SlackやLinearなどの連携を提供しました。

- VS Codeには「Plan Mode」を追加し、明確化質問と手順化で事前コンテキストを固め、承認後にローカルやクラウドエージェントで実装を開始できるようにしました。

- VS CodeでAGENTS.mdによりカスタムエージェントの振る舞いをリポジトリ管理できるようにし、再プロンプトなしで方針(例:ロガーの選好・テスト方針)を適用できるようにしました。

- GitHub MCP RegistryをVS Codeから直接利用可能にし、Stripe/Figma/SentryなどのMCPサーバーを発見・インストール・有効化して、専門ツール連携を容易にしました(VS CodeはMCP仕様フルサポート)。

- 「GitHub Code Quality」(パブリックプレビュー)を公開し、保守性・信頼性・テストカバレッジの組織横断の可視化とガバナンスを強化し、Copilotのセキュリティチェックに品質観点を拡張しました。

- Copilotのコーディングエージェントに初期コードレビュー工程を追加し、人が見る前にエージェント自身が不具合を是正する流れを導入しました。

- 「Copilot metrics dashboard」(パブリックプレビュー)で、組織全体のCopilot利用の影響や重要指標を可視化できるようにしました。

- エンタープライズ向け「コントロールプレーン」(パブリックプレビュー)で、エージェントやMCPのアクセス制御・セキュリティポリシー・監査ログ・モデルアクセスの統制・利用メトリクス取得を一元化しました。

- 既存の開発プリミティブ(Git・Pull Request・Issues・Actions/自前ランナー)を維持しつつ、エージェントを「後付け」ではなく「ネイティブ」なコラボレーターとして扱う設計を採用しました。

- 先行提供として、Copilot Pro+ユーザーはVS Code InsidersでOpenAI Codexを試用できるようになりました。

米AI研究者、週100時間労働もざら 新たなテック競争で - The Wall Street Journal

- 生成AIのブレークスルーが数カ月ごとに起きており、研究から製品化までのサイクルが極端に短縮されました。

- トップ研究者・幹部は週80〜100時間働くケースが一般化し、スタートアップでは「80時間以上」を明示した契約もあります。

- 人材獲得競争が激化し、高額報酬パッケージやCEO直下チームなどでコア人材を囲い込んでいます。

- 少人数の中核チームに負荷が集中し、夜間・週末も継続運用する体制や「キャプテン」ローテーションを導入しています。

- 企業は食事提供や常駐環境整備などで“常時稼働”を後押しし、土日のフードデリバリー需要が顕著に増加しています。

- 「996」を超える「002(毎日0時-24時、週末2時間休憩)」という極端な働き方が冗談交じりに語られる状況です。

- 研究現場ではモデルの挙動予測が難しく、計画的エンジニアリングより進化的探索に近い開発プロセスが続いています。

- 倫理・安全性への責務意識が長時間労働の動機づけにもなり、「人間に調和するAI」を急いで理解・制御しようとしています。

- マイクロソフトは「24/7はAIが担うべき」と社内でAIツール活用を促し、管理職は“第2のシフト”をAIで効率化しています。

- 生活面では休暇・趣味・人間関係が犠牲になりがちで、仕事中心のライフスタイルが広がっています。

Mercury’s Path to Product-Market Fit — Do the Hard Part First - First Round

Mercury’s Path to Product-Market Fit — Do the Hard Part First

- 最難関(規制・コンプライアンス・スポンサー銀行)から学習と検証を始めて、実現可能性を先に潰すことがPMFの近道になると示しました。

- アイデアの質を軽視せず、「会社の唯一の口座になれる」MVP要件を明確に定義し、妥協せずに時間を投資しました。

- スポンサー銀行モデルを選択し、合わないパートナーはローンチ直前でも切り替える決断を下しました。

- ローンチ前からコア機能(デジタル完結、振込/ACH/小切手、多人数権限、移民創業者対応)を作り込み、オンボーディング体験を徹底的に磨きました。

- PMFのサインは「売らずに顧客が来る」「初期不具合に顧客が寛容」「創業者がCSで溢れる」の3点を実体験として確認しました。

- MVP至上主義を鵜呑みにせず、市場や時代に合わせて「深く作る」戦略へ切り替えました。

- スケール段階では、他社のプレイブックをコピーせず、自社の人格=カルチャーを言語化・採用プロセスに埋め込みました(好奇心プレゼンなど)。

- 危機時(SVB崩壊)にCEOが感情を平準化し、同時に具体アクション(週末でのMercury Vault構築)で不安を打ち消しました。

Microsoft Plays ‘Me Too’ Again to OpenAI on AI Browser - Bloomberg

Microsoft Plays ‘Me Too’ Again to OpenAI on AI Browser

- MicrosoftはEdgeにCopilot機能を拡充して「Your AI browser」と打ち出しましたが、OpenAIが先に注目を集めて発表したChatGPT Atlasに話題をさらわれました。

- 消費者向けAIでは、CopilotがChatGPTに対して後発・模倣と受け止められ、機能の完成度や体験設計で見劣りする場面が繰り返し発生しました。

- 例として、音声モードや日次ブリーフィング、深いリサーチ、ブラウザー内アシストなどでOpenAIが先に強い体験を提示し、Microsoftは後追いの印象を与えました。

- Microsoft側の説明では、OpenAIモデルを安全かつ大規模にWindowsやOfficeへ統合する負荷やガバナンス、プライバシー配慮がスピードを制約しました。

- 組織の縦割りによってCopilot体験が分断され、単体アプリのCopilotとMicrosoft 365内のCopilotが連携不十分となり、基本的なデスクトップ操作も未対応でした。

- Microsoftは企業向けAIに注力しつつも、消費者向けの創造性や攻めの製品設計が不足していると記事は評価し、保守的姿勢が不利に働いたと論じました。

- 周辺トピックとして、AI需要に伴うデータセンター投資の過熱感(2030年までに最大約4兆ドル)やAWSの信頼性低下、半導体業界の不確実性も言及されました。

Amazon’s Slower Growth in AI Cloud Business May Not Be Fatal Flaw - Bloomberg

Amazon’s Slower Growth in AI Cloud Business May Not Be Fatal Flaw

- AWSはAIブーム以降、AzureやGoogle、Oracleに比べて成長率が見劣りすると指摘されましたが、依然として30〜40%の大きな市場シェアを維持しています。

- 競合がOpenAIやMetaなどと超大型AI計算契約を結ぶ中で、AWSは目立つ“億ドル級AI案件”に乏しいとみなされました。

- その一方で、AWSは需給逼迫を公表し、自社のデータセンター増設とAnthropicへの巨額コミットなど“選択と集中”を進めています。

- 巨額AI案件は建設コストや原価が重く、短期的に低マージン化しやすいため、AWSの慎重姿勢は収益性を守る戦略と解釈できます。

- AI投資が短期的にバブル的様相を帯びるとの見方もあり、供給能力や実需の裏付けが弱い案件を避けることに一定の合理性があります。

- 近々の決算(Microsoft、Google、Amazon)が、受注残や設備投資、供給能力の見通しを通じて各社の戦略の成否を占います。

OpenAI Completes For-Profit Transition, Pushing Microsoft Above $4 Trillion Valuation - The Wall Street Journal

OpenAI Completes For-Profit Transition, Pushing Microsoft Above $4 Trillion Valuation

- OpenAIは営利子会社を公益目的会社(Public Benefit Corporation)に転換し、上場準備を前進させました。

- Microsoftは新体制のOpenAIの27%を保有し、時価総額が約4兆ドルを突破しました。

- OpenAIの非営利親法人は「OpenAI Foundation」に改称し、約1,300億ドル相当の持分を得て、医療・AIレジリエンスに最初の250億ドルを拠出すると表明しました。

- Microsoftは2032年までOpenAI技術の独占的IP権を保持しますが、Azureの優先供給権は失いました。

- OpenAIはMicrosoftのAzureを追加で2,500億ドル分購入する契約を結びつつ、他クラウドも併用する方針を示しました。

- 2024年末までの転換条件は投資家拠出の前提であり、今回の移行が資金調達継続に不可欠でした。

- 旧構造の「利益上限(初期投資の最大100倍)」モデルは、PBC化でより一般的な株式主義に近づきました。

- カリフォルニア州・デラウェア州の司法当局との協議を経て、非営利が統治権を一定程度維持する形で決着しました。

- xAIなどからの法的挑戦は継続しており、ガバナンスや非営利ミッションとの整合性を巡る論点は残っています。

- AI投資熱は関連銘柄の株価急騰を招き、インフラ支出の過熱やバブル懸念も強まっています。

MiniMax-M2 is the new king of open source LLMs (especially for agentic tool calling) - VentureBeat

MiniMax-M2 is the new king of open source LLMs (especially for agentic tool calling)

- MiniMax-M2はMITライセンスで公開され、商用利用や再学習、自己ホスティングを自由に行えることを特徴としました。

- MoE(Mixture-of-Experts)で総230B・アクティブ10B構成を採用し、高い推論性能を維持しながらGPU負荷とレイテンシを抑えました。

- Artificial AnalysisのIntelligence Indexで61点を獲得し、オープン重量級で最高位となり、推論・コーディング・エージェント指標で上位機種に肉薄しました。

- τ²-Bench 77.2、BrowseComp 44.0、FinSearchComp-global 65.5など、計画・実行・外部ツール活用の実務系ベンチで強みを示しました。

- エージェント向けに「

… 」の可視思考(インタリーブド思考)を保持し、手順計画や検証のトレース性を高めました。 - ツールコーリングをXML風の構造化呼び出しで指南し、検索・取得・計算など外部機能を一貫して連携できるように設計しました。

- 提供価格はAPIで入力$0.30/MTok、出力$1.20/MTokと競争力があり、長い思考出力でもコストパフォーマンスを保ちました。

- FP8でNVIDIA H100×4台でも提供可能とされ、ミッドサイズ組織でも導入しやすい運用要件を示しました。

- SGLangやvLLMが思考インタリーブとツール呼び出し仕様に即日対応し、配備の摩擦を下げました。

- 背景としてMiniMaxは動画生成や長文脈モデルで実績を重ね、オープン・効率・実用性重視の路線を加速させました。

サイバー攻撃「まるでトクリュウ」 企業標的、闇サイトで請け負い - 日本経済新聞 - 日本経済新聞社

サイバー攻撃「まるでトクリュウ」 企業標的、闇サイトで請け負い - 日本経済新聞

- ランサム集団「Qilin」は協力者へ最大8割の歩合を提示し、短期間で攻撃規模を拡大しました。

- 協力者は闇求人やTelegram経由で参加し、流出認証情報の闇市場を活用して侵入から暗号化まで手順通りに実行しました。

- 盗取対象にサイバー保険契約を含めることで、支払い可能性に応じた身代金額を算定しました。

- 組織は匿名・流動的に連絡し、週5勤務や休暇申請など企業風の運用を行いながら実質は犯罪活動を継続しました。

- 開発者や実行役はフリーランス的に関与し、逮捕が末端に偏るため中枢特定と抑止が難航しました。

- 攻撃対象は製造、医療、テック、金融、さらには政府機関まで広がり、社会インフラの連鎖的混乱リスクが増大しました。

ShadCN Themer - Create Beautiful Themes for shadcn/ui - Mike Tromba

ShadCN Themer - Create Beautiful Themes for shadcn/ui

Why I code as a CTO -

- CTOが手を動かしてコードを書くことで、新規プロダクトの実験から本番投入までを素早く推進できると述べました。

- 重要顧客の緊急要望に対して、全体アーキテクチャ理解を武器に最短で価値提供できると説明しました。

- 日常的なバグ修正を通じてコードベース全体を横断的に把握し、技術的負債や複雑性の勘所を養えると主張しました。

- AIコーディングツールの活用で生産性が2〜3倍に向上し、判断力と文脈知がより重要になったと強調しました。

- AIの得手不得手を踏まえ、CRUDやテスト生成はAIに任せ、精密なロジックやシステムの微妙な挙動は人が担うべきと整理しました。

- 自身は組織設計よりものづくりが得意であり、優秀なEMを採用して役割分担することで最大価値を発揮したと述べました。

- CTOの役割は文脈依存で多様であり、自分の強みと会社のニーズの交差点で設計すべきだと提案しました。

The Search Problem: Why Your Computer Finds Things Faster Than You Do - Imposter -

The Search Problem: Why Your Computer Finds Things Faster Than You Do - Imposter

- O(log n)は「1比較のコストが同じ」という仮定に依存すると理解し、ディスクでは1回のアクセスが高コストになるため、比較回数よりも「ブロック読み込み回数」を最小化することが重要だと認識します。

- B木は1ノードに多数のキーと子ポインタを持たせ、ノードサイズをディスクブロック(例: 4KB)に合わせることで、1回のディスク読み込みで多数の比較を実行できるように設計されていると理解します。

- B木の高さは「データ件数」ではなく「ブロック数」に対して対数で増加するため、100万件でも3〜4段で到達し、3〜4回のI/Oで検索できることを把握します。

- BSTは入力順序に依存して最悪ケースで高さがnに達し、ディスクI/O環境では性能が壊滅的に悪化する一方で、B木は分割・借用・マージにより常にバランスを保つと理解します。

- ファイルシステム(ext4/NTFS/APFS/Btrfs)やDB(MySQL/PostgreSQL/MongoDB)など、I/O主導のシステムがB/B+木を用いる理由は、最悪時でも少数のI/Oで応答を保証するためだと把握します。

- 実務では「平均」より「ばらつきと最悪ケース」を重視し、コストモデル(RAM/ディスク/ネットワーク)に合ったデータ構造を選ぶべきだと心に留めます。

- インデックスの挙動を理解し、先頭ワイルドカードLIKEでB木が効かない、複合インデックスの左端一致、ORDER BYの恩恵など、クエリ作成時に性能を崩さない使い方を徹底します。

Starbase by Metorial - @metorialAi

Introducing Mistral AI Studio. | Mistral AI -

Introducing Mistral AI Studio. | Mistral AI

- 多くの企業がモデル性能ではなく「運用基盤の欠如」によって本番化に失敗していることを問題提起しました。

- Mistral AI StudioはObservability(観測)、Agent Runtime(実行基盤)、AI Registry(資産管理と統治)の三本柱で運用課題を包括的に解決します。

- 観測では実トラフィックの追跡、評価指標の設計、回帰検知、ダッシュボード化を通じて改善ループをデータ駆動で回せるようにしました。

- 実行基盤ではTemporalを用いた状態管理とリトライ耐性を備え、長時間・多段のエージェント処理を再現可能に運用できるようにしました。

- レジストリではエージェント、モデル、データセット、ジャッジ、ツールの系譜とバージョンを一元管理し、アクセス制御や承認ゲートでガバナンスを担保しました。

- ハイブリッド、専有、オンプレまで柔軟にデプロイでき、データ主権やセキュリティ要件に合わせて運用できるようにしました。

- プロトタイプから本番までを一続きの評価・改善ループに繋げ、各リリースを計測可能かつ説明可能にしました。

💫 The Rise of Contextual AI: How Miro and Amplitude Are Making Products That Actually Understand You - Growthmates with Kate Syuma

💫 The Rise of Contextual AI: How Miro and Amplitude Are Making Products That Actually Understand You

- 文脈理解を組み込んだAIが主役に移りつつあり、言語だけでなく行動データを理解した意思決定が可能になりました。

- Amplitude MCPはLLMにプロダクトの行動データを安全に接続し、自然言語で実験結果やファネルを即座に分析できるようにしました。

- Miro Canvas 25はAIをボード上の共同作業に埋め込み、発散・整理・要約を「作業の流れ」の中で支援しました。

- 週次活性化が長期維持率の最重要ドライバーとなり、上位25%は7日目リテンション7%到達が基準になりました。

- 獲得量と維持率に相関はなく、活性化の弱い獲得は「穴の空いたバケツ」になりやすいことを示しました。

- 上位10%のプロダクトはリアルタイムの行動シグナルでオンボーディングやナッジを動的に最適化し、全体エンゲージメントの79%を生み出しました。

- 企業向けでは活性化12.4%と2.1%の大きな差があり、役割・意図・初回行動に応じた深いパーソナライゼーションが差を生みました。

- データは最適化だけでなく新規価値の発見に用いられ、戦略の方向付けそのものを行動データから導くことが重要になりました。

- 実践原則は「文脈を競争優位にする」「活性化を最優先する」「ハイパーパーソナライズ」「AIは相棒として組み込む」「洞察を即時アクション化する」です。

A Historical Take on the AI Boom - Rich Mironov’s Product Bytes

A Historical Take on the AI Boom

- 1995年のウェブ、2008年のモバイルと同様に、最初は「専用職種」やPR的投資が過熱しましたが、のちに機能の一部として統合され、スキルが“必須の資格”へと位置づけられました。

- ウェブとモバイルは結局「ほとんどのプロダクトに内蔵される要素」になり、職種名からは消えましたが、スキルの重要性は増しました。

- 現在のAIは規模が桁違いで、プラットフォームやツールの合算評価額は実収益では正当化できず、原価割れ価格も多く、資金調達前提のビジネスが目立っています。

- 近い将来に大幅な評価見直しやサービス停止が起きる可能性が高く、次の資金調達は明確な経済合理性を示す説明力に依存すると予測しています(目安は2026年中頃)。

- 成熟に向かうにつれて、派手なデモよりも“地味だが効く”実務ユースケースが勝ち、AIは話題性よりも実用性が評価される段階に移行します。

- 採用市場では「AIプロダクトマネージャー」という肩書は薄れ、プロダクトや市場起点の職種名に戻り、AI経験はシニア職の前提条件になります。

- AIはプロダクトマネージャーを置き換えませんが、生成物を高速に出荷できる分、“スロップ(粗いプロダクト)”を量産するリスクが増すため、顧客理解と価値選別の力量がさらに重要になります。

AI can code, but it can’t build software | ByteSauna -

AI can code, but it can’t build software | ByteSauna

- AIは「よく定義された局所的な問題」を解くコーディングは高い確率で成功させますが、プロダクション品質への仕上げは別問題であると述べました。

- ソフトウェアエンジニアリングの本質は「多数の簡単なことを同時に、整合的に、長期にわたり維持可能に進める複雑性の制御」にあると説明しました。

- デモ段階から製品段階に移行するタイミングで、統合性・拡張性・保守性が要求され、AI生成コードでは根本から作り直しが必要になるケースが多いと指摘しました。

- 「技術共同創業者を探す人が増えている」という現象は、AIだけではプロダクションに到達できない現実のシグナルだと解釈しました。

- 現時点でAIがソフトウェアを「構築」できない理由は断定できないものの、作業の性質上、複雑性管理と全体設計が鍵であり、ここが自動化の難所だと示唆しました。

Importing vs fetching JSON -

- 静的importでJSONが失敗した場合、モジュールグラフ全体が落ちるため、第三者提供の不安定なJSONには向いていないと説明しました

- import() と fetch() の両方で例外処理は可能ですが、fetch() は response.status や response.text() により失敗理由を詳細に診断できると指摘しました

- モジュールとして読み込まれたJSONは環境のライフタイム中キャッシュされ、型とspecifierが同一なら同じモジュールを返すと説明しました

- import() を検索APIのような動的URLに使うと、各結果がモジュールグラフに残り続け、ページの寿命まで解放されずメモリリークになると注意喚起しました

- fetch() で得たオブジェクトは参照が切れればガベージコレクション対象になり、不要メモリを解放できると説明しました

- 大きなJSONをimport() し、必要部分だけを使っても、モジュールキャッシュにより全体がメモリに残るため非効率だと強調しました

- JSONモジュールはローカルで静的かつほぼ全量を使うデータに限定して有効だと提案しました

- フロントエンドで package.json をimportすると不要データまでバンドルされがちで、通常は非効率だと述べました

- 一部のバンドラ(esbuild/Vite/Rollup)は非標準構文でトップレベルキーの個別エクスポートを提供し、トップレベルのみツリーシェイクが可能だと補足しました

- ランタイムの「fetchして加工する」処理は、可能ならVite/Rollupのプラグインとしてビルド時に行うべきだと提案しました

johannschopplich/toon: 🎒 Token-Oriented Object Notation – JSON for LLMs at half the token cost - GitHub

johannschopplich/toon: 🎒 Token-Oriented Object Notation – JSON for LLMs at half the token cost

Strengthening ChatGPT’s responses in sensitive conversations - OpenAI

Strengthening ChatGPT’s responses in sensitive conversations

- GPT‑5を中心に、精神的な危機(精神病・躁状態)、自傷・自殺、AIへの情緒的依存の3領域で安全性を重点強化しました。

- 170名超の精神科医・心理士・プライマリケア医と連携し、望ましい応答と望ましくない応答を定義する詳細なタクソノミーを整備しました。

- 本番トラフィックで、望ましくない応答の発生率をおおむね65〜80%削減しました(領域により差異があります)。

- 自傷・自殺に関する困難なケースで、専門家評価によりGPT‑4o比で不適切応答を39〜52%減らしました。

- 自動評価(難問セット)で、メンタルヘルス領域はGPT‑5が92%適合、情緒的依存は97%適合など大幅改善を示しました。

- 低頻度イベントのため、実運用データだけに依存せず、難易度の高いオフライン評価と独立専門家の採点を継続しました。

- 機能面では、危機ホットラインの拡充、他モデルから安全モデルへのリルーティング、長時間対話での休憩を促す介入を追加しました。

- モデル仕様(Model Spec)を更新し、現実の人間関係の尊重、根拠のない苦痛関連信念の肯定回避、間接的な自傷・自殺兆候への感度向上を明文化しました。

- 長文・長時間対話の信頼性を改善し、困難な長対話でも95%以上の安定性を維持しました。

- 測定上の前提として、該当対話は極めて稀であり、精度と再現率のトレードオフや指標の成熟度によって数字が変動しうることを開示しました。

On-Policy Distillation - Thinking Machines Lab

- LLMの学習は「事前学習(一般能力)→中間学習(領域知識)→後段学習(振る舞い)」の三段構成で設計すると効果的であると説明しました。

- 小型モデルは適切な中間・後段学習を行うと、特定領域では大型汎用モデルを上回ることがあると述べました。

- 後段学習の主流は二系統であり、オンポリシー(RL)とオフポリシー(SFT/蒸留)に分かれることを整理しました。

- RLは自己サンプルに紐づく学習で誤り回避を直接学べますが、報酬が疎で学習効率が低いという欠点があると説明しました。

- オフポリシーSFT/蒸留は高品質データから密な信号で学べますが、学生自身の状態分布から外れやすく長い生成で誤差が累積する課題があると述べました。

- オンポリシー蒸留は学生の出力軌跡を教師が各トークンで採点し、密な報酬で自己状態に整合した学習を実現すると説明しました。

- 逆KLをトークン単位で最小化する目的を用い、学生分布を教師分布にモードシーキングで近づけ、露出バイアスを軽減すると述べました。

- 実装はRLパイプラインに近く、教師のlogprob計算を用いて逆KLをそのまま「負の利得」として重要度サンプリング損失に入れると説明しました。

- 数学推論タスクで、SFT追加200万プロンプト相当のコストと比べ、オンポリシー蒸留は約9〜30倍の計算効率改善を観測したと述べました。

- パーソナライゼーション文脈では、社内文書での中間学習でIF-evalが劣化しても、オンポリシー蒸留により振る舞いを安価に回復できたと報告しました。

- 連続学習(継続的な知識更新)では、知識は中間学習で、振る舞いはオンポリシー蒸留で交互に補正する「位相的」学習が有効だと示唆しました。

- 密な監督は計算効率を大幅に引き上げ、同一初期化でRLが学んだ戦略を蒸留が7〜10倍少ない更新で再現でき、総計算では50〜100倍の効率差になり得ると述べました。

- オンポリシー蒸留は同一プロンプトの多エポック再利用にも適し、最終戦略の近似に集中できるためデータ効率が高いと説明しました。

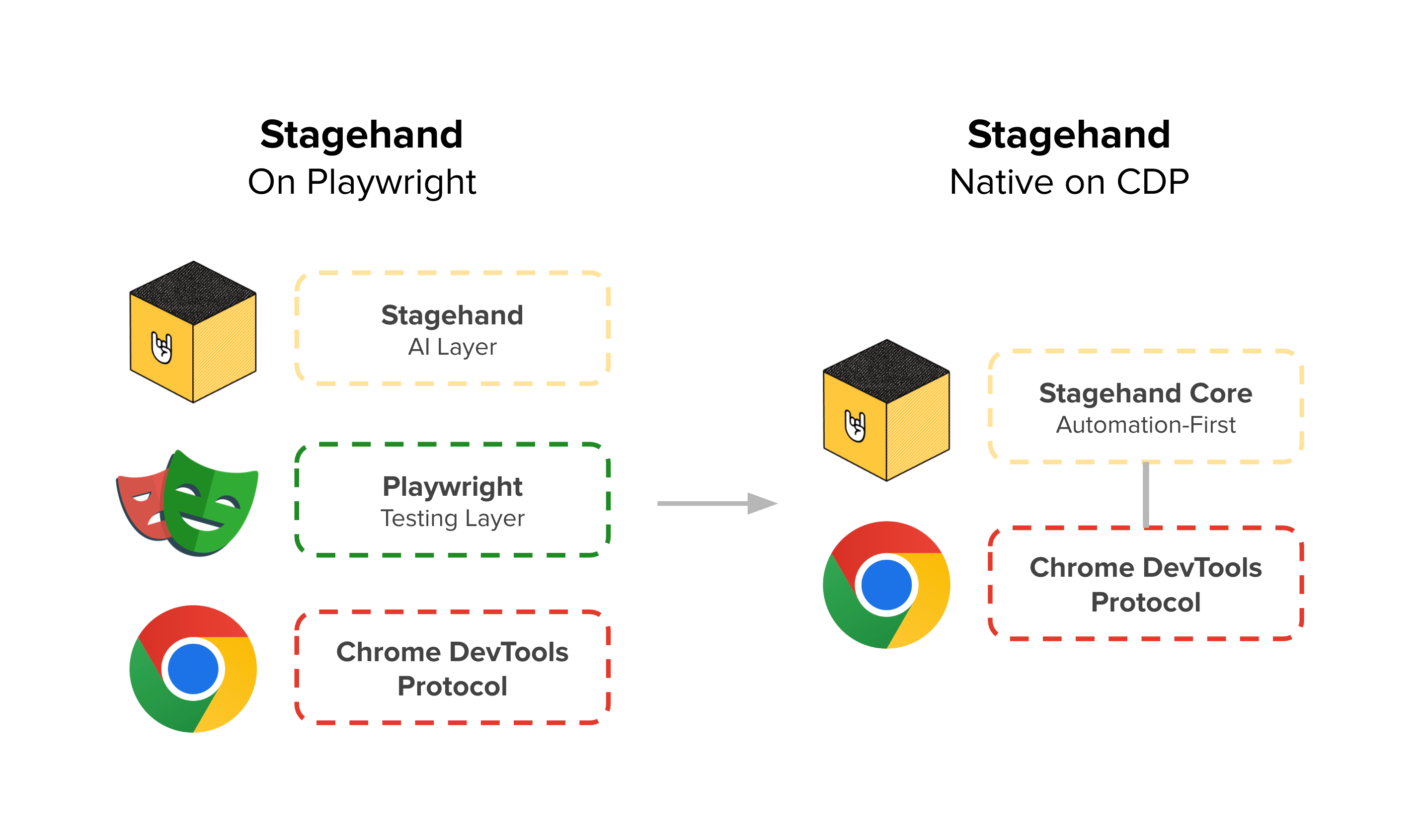

Why Stagehand Is Moving Beyond Playwright - Why we’re graduating from Playwright

Why Stagehand Is Moving Beyond Playwright

- StagehandはPlaywright互換から始めて採用障壁を下げ、AIプリミティブ(act/extract/observe)を同じPage/Context上で提供しました。

- スケールに伴い、テスト指向の待機・アクショナビリティが自動化のスループットを下げる場面が増えたと述べました。

- CDP(Chrome DevTools Protocol)を前提とした精密な制御が必要になり、特にiframeの識別・スコープ管理でPlaywrightの抽象化が摩擦を生みました。

- Playwrightは固有のフレームIDを公開しないため、ライフサイクル追跡やフレーム別CDPルーティングの実装が複雑になりました。

- 長時間稼働セッションでのメモリ成長やバージョン依存の退行により、運用上のヘッドルームを自分たちで選べる設計が必要になりました。

- 学びとして、最短の導入路は有効だった一方で、巨大なテスト用API表面積の維持が自動化特化の機能開発速度を制約すると結論づけました。

- 今後は「自動化ファーストのセマンティクス」「CDPネイティブの性能」「小さなコア」「重要箇所での互換性維持」という原則で設計すると表明しました。

- 目的は、モデルと開発者が信頼できるブラウザ実行環境を提供し、予測可能な振る舞いとネイティブに近い性能を実現することにあります。

Why we built TLDW - Zara’s Newsletter

- テキスト要約は動画の高密度な情報と視覚的・情緒的な手がかりを削ぎ落としてしまうため、学習効率が下がると指摘しました

- 同じ動画でも人によって関心領域が異なるため、汎用的な要約では満足度が低くなると説明しました

- 「圧縮」ではなく「選別・キュレーション」にAIを使い、必要な5分だけを原動画のクリップとして提示する設計にしました

- 進行バーに色付きの“ハイライトリール”を表示し、クリックで該当箇所へ即ジャンプできるようにしました

- キーワードを選択して「Explain」を押すと、動画全体の文脈を踏まえて用語をその場で解説する機能を実装しました

- 気になる一文を選んで「Take notes」を押すと、個人ノートに自動保存する仕組みを用意しました

- 動画トランスクリプトに対してチャットで質問し、名言や特定トピックへの見解などを対話的に取り出せるようにしました

- 視聴履歴とノートを一元管理し、個人の学習ハブとして継続的に使えるように設計しました

- 今後はクリップ共有、マルチリンガル対応、嗜好学習によるより高度なパーソナライズを追加する計画を示しました

- プロジェクトは3人のチームが情熱ベースで夜間・週末に開発し、コードをオープンソースとして公開しました

Thread by @a16z - X (formerly Twitter)

Amjad Masad and Marc Andreessen on AI agents, AGI, Creativity, and Reasoning

— a16z (@a16z) October 23, 2025

Agents are getting better, fast. Replit Agent v1 could do only 2 minutes of coherent work. v2 could do 20 minutes. Today’s v3? 200 minutes. As agents get more and more reliable, we can make huge… pic.twitter.com/g6rJErCWwS

How CEOs Manage Stress - Harvard Business Review

- ストレスを前提条件として受け入れ、コントロールより「転化(reframing)」を重視しました。

- 高圧の場面では、意思決定の枠組み(原則・時間軸・最悪シナリオ)を先に固定して迷いを減らしました。

- 自己懐疑に陥る前に、事実ベースのチェックリストと信頼できる少人数の助言網で認知の歪みを補正しました。

- 1日の「エネルギー予算」を可視化し、集中タスク、対人、創造のブロックを時間帯で分離しました。

- ルーティン(睡眠・運動・食事・デジタル境界)を「非交渉項目」として予定に先置きしました。

- ストレスの身体反応(呼吸・心拍・体温)を短時間で整えるマイクロ介入を習慣化しました。

- チームには「ストレスの透明性」を段階的に共有し、心理的安全性と危機モードの切替えを明確にしました。

- 意味づけ(パーパス)と価値観に毎週立ち返り、短期の混乱と長期の方向性を結び付けました。

How Gen AI Can Create More Time for Leadership - Harvard Business Review

How Gen AI Can Create More Time for Leadership

- 従業員エンゲージメントと経営への信頼が低下しているため、リーダーの人間的スキル強化が急務であると示されました。

- 研究では、人間的資質が低いリーダーのもとで信頼が49%低く、離職意向が59%高いことが示されました。

- 生成AIの導入を単なる時短で終わらせず、「浮いた時間を人に向き合う行為」に再配分する設計が必要だと述べられました。

- IBM事例では、昇進や人事手続きのAI自動化(AskHR)が処理時間を約75%短縮し、対話やフィードバックに時間をあてる期待値を明確にしました。

- パフォーマンス評価に「リーダーシップ行動(People・Execution・Strategy)」を組み込み、特にPeople領域で真摯さ・勇気・共感を求める基準を設定しました。

- 360度フィードバックを大規模に実施し、自己認識を高めるとともに、トレーニングや会話ガイドで具体行動を支援しました。

- AIは「関係を自動化」するのではなく「人間的存在感を増幅」する用途に限定し、常に人が介在して自分の言葉で伝える方針を掲げました。

- 具体的ステップは、①時短AIを人間的リーダーシップ強化の機会に再定義する、②節約時間をソフトスキル育成に投資する、③生成AIをコーチとして活用する、の3段階でした。

Middle Managers Feel the Least Psychological Safety at Work - Harvard Business Review

Middle Managers Feel the Least Psychological Safety at Work

- 調査では心理的安全性スコアが中間管理職で最も低く、CxOより4.7ポイント、直属部下よりも4.2ポイント低いことが示されました。

- 昇進3年未満の新任中間管理職が特に低く、目立つ失敗への恐れと不確実性が沈黙を招くことがわかりました。

- 中間層の沈黙は、トップのエラーブラインド化、現場の模倣による「失敗を隠す文化」、実験の停滞、長期的な学習の劣化につながります。

- 主因は、失敗のスティグマ化、経営層の脆弱性の不十分な模範、学習を支える制度の欠如、同僚支援の希薄さ、移行期支援の不足です。

- 有効策として、正当なアカウンタビリティ設計(誠実な失敗を学習機会として扱う)、経営層の失敗共有と非断罪的な問いかけ、ニアミス共有プラットフォーム、同僚コーチングの場、新任向けの失敗リテラシーとメンタリングが挙げられます。

- 中間層の心理的安全性を高めることは、戦略と実行のフィードバックループを回復し、組織の機敏性とイノベーションを維持するために不可欠です。

Our Favorite Management Tips on Leading Through Uncertainty - Harvard Business Review

Our Favorite Management Tips on Leading Through Uncertainty

- 恐れを行動の物語に置き換えて自己効力感を高め、目的に基づいて小さく素早く動きました。

- 能力を計画的に磨き、コントロールできる領域に集中して自信を積み上げました。

- マイクロステップで仮説検証を回し、学習から次の一手を明確にしました。

- 仲間からの支援・フィードバックを求め、意思決定の質と心理的安全性を高めました。

- 休息・儀式・リフレーミングで感情を整え、落ち着いた態度で判断しました。

- 逆風が強い領域では「戦略的冬眠」を選び、コア資産を維持しつつ再始動の選択肢を確保しました。

- 情報が少ないときほど透明性を重視し、事実に基づいて進捗と優先順位を伝えました。

- 一律の削減を避け、「効率・レジリエンス・存在感」の三重テストで賢く引き算しました。

- 複雑さを簡素化・統合・隠蔽・一時停止・抽象化で扱い、ユーザー負荷を下げました。

- 短期に流されず、「1年後も妥当か」「教材になる意思決定か」「嵐ではなく気候か」「待つコストは何か」を問い直しました。

- 年次固定計画から常時シナリオ型に移行し、クロス機能で兆しを機会に変えました。

- 出社一律ではなくパフォーマンス基準で働き方を設計し、明確なマイルストンで説明責任を担保しました。

- 失敗をデータとして扱い、スモールパイロットから素早く拡張しました。

- 原則を明文化した迅速意思決定プレイブックを用い、学びに応じて戦略を更新しました。

- 目的を語り、自ら価値観を体現し、結果に囚われすぎず冷静さを示して信頼を築きました。

意外に深い「オリオンビールは、なぜ上場したのか」 - NewsPicks編集部

- 予期せぬ親族間の株式譲渡が引き金となり、2019年に野村系とカーライルによる買収が実現したことが起点になりました。

- 非上場のまま株主が599人に膨張し、配当不満や株式買取要求が噴出したことで、ガバナンスリスクが臨界点に達していました。

- 創業家の資産管理会社(幸商事)と「同居」する構造や低配当慣行が、経営の自由度と透明性を損なっていました。

- 酒税軽減措置の終了リスクや県内シェア低下を前に、不動産投資など非中核へ傾斜していた経営を、ファンドが本業集中に再設計しました。

- 不動産を売却して資本効率を改善し、得た資金は配当原資となり、ファンドは約2倍超のリターンを確保しました。

- 県外・海外販売を伸ばして売上高を過去最高へ引き上げ、調整後EBITDAが50億円超に到達しました。

- 上場により、創業家・地元のしがらみから離れ、公開市場の規律の下で「企業価値の最大化」に一本化しました。

- 酒税軽減の完全終了(来年9月末)前に上場を果たし、リスク移行期の資金調達力と機動力を確保しました。

Taming iframes: A Stagehand Update - Taming iframes: A Stagehand Update

- StagehandはAXツリーとDOMツリーを統合してページを階層文字列に変換し、LLMが要素を理解しやすくしました。

- すべてのフレーム(同一プロセス/OOPIF)をDFSで巡回し、各フレームのAXツリー・URL・XPathをスナップショット化して統合しました。

- フレーム序数 + backendNodeIdでグローバル一意なEncodedIdを生成し、iframe間で重複するNode IDの曖昧さを解消しました。

- 「Deep XPath Locator」を導入して、XPathのiframeステップごとにPlaywrightのframeLocatorで文脈を切り替えながら最終要素に到達できるようにしました。

- CDPセッションをPage/Frameにひも付けてWeakMapで管理し、ネスト/OOPIFでも正しい文脈にCDPコマンドを送れるようにしました。

- エンドユーザーはextract/observe/actが全フレームで動作する恩恵を受け、自然言語の指示だけで深いiframe内の要素にも操作が届くようになりました。

Mem0 raises $24M from YC, Peak XV and Basis Set to build the memory layer for AI apps - TechCrunch

- Mem0はAIアプリに長期記憶を付与する「メモリパスポート」を提供し、アプリやエージェント間でユーザー記憶を持ち運べるようにしました。

- 2024年創業で累計$24M(約¥3,600,000,000)を調達し、Series AはBasis Setが主導し、YC、Kindred、Peak XV、GitHub Fundなどが参加しました。

- オープンソースAPIはGitHubで41,000超のスターと1,300万超のPyPIダウンロードを獲得し、2025年Q1の3,500万APIコールからQ3に1億8,600万まで約30%の月次成長を実現しました。

- クラウド版には8万人超の開発者が登録し、AWSの新Agent SDKで“専用メモリプロバイダ”として採用されました。

- Mem0はモデル非依存で、OpenAI・Anthropic・OSS LLMに対応し、LangChainやLlamaIndexとも統合しました。

- 競合としてOpenAIの内製メモリ機能やSupermemory、Letta、Memories.aiが存在しますが、Mem0はポータブルで中立なメモリ層を志向しました。

- 創業者はEmbedchainやEvalAIなどOSSの実績を持ち、プロダクトピボットの起点は「アプリがユーザーの旅路を覚えない」課題に直面した体験でした。

What the OpenAI Restructuring Means - The Information

- OpenAIは1年かけた再編を完了し、将来的なIPO(新規株式公開)に向けた基盤を整えました。

- 統治は非営利のOpenAI Foundationが握り続け、取締役の任免権を通じて営利会社を実質的にコントロールすると説明しました。

- 既存の投資は通常株式に転換され、過去のリターン上限(キャップ)は撤廃されました。

- 株式構成は概ねFoundation 26%、Microsoft 27%、従業員・元従業員・一部投資家の合計約26%などとなり、時価評価に基づく巨額の持分価値が生じました。

- MicrosoftはOpenAIから長期のサーバーレンタル(累計約2,500億ドル相当)のコミットメントを獲得し、同様のコミットメントをOracleとも結びました。

- OpenAIは2030年代までにデータセンター30GW相当の利用・開発コミットメントから約1.4兆ドルの「財務上の義務」を抱える一方、2025年の売上予測は約130億ドルにとどまると説明しました。

- FoundationはOpenAIの評価額が15年内に5兆ドルを超える場合に追加株式を得るワラントを保有し、初期の約250億ドル相当を社会的研究(健康・AIリスク緩和など)に投じる方針を示しました。

- 安全・セキュリティに関しては、企業価値より「人類への便益」を優先する条項を定款に盛り込み、安全委員会の独立性を確保しました。

- Microsoftとの関係は相互に自由度が増し、OpenAIは他クラウドとも提携でき、MicrosoftはAnthropicなど競合モデルの採用・販売に積極姿勢を示しました。

- Microsoftは2032年までにOpenAIが開発する製品群の知的財産を継続利用できる権利を維持し、消費者向けハードウェアのIPは対象外とされました。

- 再編によりIPOへの道が開け、ソフトバンクなどからの大型資金(総額約410億ドルのラウンドの一部)が条件付きで確定し、従業員持株の流動化にも追い風が吹きました。

The Creative Dealmaking Behind Meta’s $30 Billion Data Center Financing - The Information

- メタはルイジアナ州の巨大AIデータセンター「Hyperion」向けに約$30Bの資金を確保しました(約$27.3Bのボンド+$2.5Bのエクイティ)。

- 資金調達はSPV(Beignet Investor)を用いる構造で行い、Blue OwlがSPVの80%を保有して経営を主導しました。

- この構造により$30Bのデットをメタ本体のバランスシートから切り離し、長期負債の増加を回避しました。

- データセンター利用契約は20年固定ではなく4年更新の短期リースを連ねる形とし、会計上の金融リース認定を避ける設計にしました。

- SECから提案された会計処理への書簡を得て見解を確認し、ムーディーズとS&Pからも格付け面への即時悪影響がない旨を取り付けました。

- 発行債はA+格付けでクーポン約6.6%と魅力的な水準となり、PIMCOやBlackRock、保険マネーなど長期投資家が大量に購入しました。

- 満期は2049年と超長期で、年金・保険など長期負債を抱える投資家の需要に合致しました。

- メタは早期にプロジェクトから撤退できるオプションを保持し、残存価値保証(RVG)で投資家を保護する一方、即時の負債計上は回避しました。

- 同様のスキームはxAIのColossus 2でも活用されており、AIインフラの巨額調達で新たな標準になり得ます。

Apple Supplier Skyworks Agrees to Buy Rival Qorvo for $10.6 Billion - The Information

- SkyworksがQorvoを現金と株式の組み合わせで約106億ドル(約1.6兆円)で買収すると発表しました。

- Qorvo株主は1株当たり現金32.50ドルに加え、Skyworks株0.96株を受け取る条件となりました。

- 買収プレミアムは取引前のQorvo時価総額比で約25%となりました。

- 統合後、Skyworksが約63%を支配し、CEOはSkyworksのPhil Brace氏が務める予定です。

- 目的はBroadcomやQualcommといった大手に対抗するための規模拡大と製品力強化にあります。

- 両社はApple向け無線(RF)部品の受注減に直面しており、特にSkyworksはApple向け比率の低下を見込んでいます。

- スマホ市場の伸び鈍化と買い替え周期の長期化が事業環境を厳しくし、サプライヤー間の競争が激化しています。

- 報道後にSkyworks株は約13%、Qorvo株は約11%上昇し、市場は再編によるシナジー期待を示しました。

- QorvoはApple依存度が高く、直近期では売上の約47%をAppleが占めていました。

- 半導体業界では需要鈍化局面で同業再編が進んでおり、本件もその流れの一環といえます。

Nvidia and OpenAI Flood the Zone With AI News - The Information

- OpenAIが「ほぼ通常の株式会社」に近づく再編を完了し、将来の上場可能性を開きましたが、非営利法人が実質的な支配を維持しました。

- カリフォルニア州司法長官は再編に異議なしのメモを出しましたが、イーロン・マスク氏の訴訟は継続し、法的な不確実性が残りました。

- OpenAIのサム・アルトマン氏は、今後数年の計算資源コミットが1.4兆ドル規模に達したと公表し、垂直統合を加速する姿勢を示しました。

- MicrosoftはOpenAIへの出資価値が約1,350億ドルに膨らみ、戦略的リターンが拡大しました。

- NvidiaはGTCで、2026年末までの新チップ受注の規模を開示し、Uberや自動車メーカーと自動運転分野で提携を発表しました。

- Nvidiaの自動運転強化はロボタクシー戦略を掲げるTeslaとの競争関係に影響を与える可能性があります。

- OpenAIは一般向けライブ配信で研究方針や社会的影響に関する質疑に応じ、透明性をアピールしました。

- 業界動向として、SkyworksによるQorvo買収、Whatnotの大型資金調達、AdobeとGoogleのAI連携拡大、SecuritizeのSPAC上場、Seresの香港上場計画、Amazonの約1.4万人の人員削減が報じられました。

Profit Pressure Spurs Chip Deals - The Information

- Apple向け売上の減少が続くSkyworksとQorvoが合併に踏み切り、約100億ドル規模の再編によって規模の経済を確保しようとしました。

- AI半導体ではNvidiaの支配力とCUDAエコシステムの強さが競合の商機を狭め、資金調達難や早期売却(SambaNovaやRivosなど)の動きを後押ししました。

- 人材・設計力の獲得を狙った「アクハイア」(ライセンス+人材獲得型の取引)が活発化し、AMDやMeta、Nvidiaが布石を打ちました。

- データセンターのボトルネック解消(高速接続・メモリ帯域・電力効率)が次のM&A焦点となり、Alphawave、Enfabrica、光インターコネクト各社が注目を集めました。

- 地政学・規制の変動(米中関係、対中東輸出規制の緩和観測)が売却先・買収可否・評価に影響し、案件の成立可能性を左右しました。

- MicrosoftやIntelなどの遅れ組・巻き返し組が買収候補として浮上し、ハイパースケーラーやレガシー半導体の動きが活発化しました。

Uber and Nvidia Target 100,000 Self-Driving Cars - The Information

- UberとNvidiaが提携し、Stellantisが車両を生産してロボタクシーとして運用すると発表しました。

- Uberはまず5,000台の導入を見込み、Nvidiaは提携全体で長期的に10万台規模を支える計画を示しました。

- 主要競合としてWaymoとの既存提携やTeslaのロボタクシー展開があり、勢力図が動く可能性があります。

- Nvidiaは新プラットフォーム「Drive AGX Hyperion 10」を中核に、あらゆる車両の自動運転化を狙う戦略を明確にしました。

- Stellantisに加え、LucidやMercedes-Benz、Aurora、Volvo Autonomous Solutions、WaabiなどがNvidia技術の採用を進めています。

- UberとNvidiaは、Nvidiaの動画生成AI「Cosmos」を活用し、学習用データやシミュレーション強化による自動運転ソフトの開発を加速します。

- 量産と運用開始のターゲットは2027年であり、大規模展開までの技術・規制・安全性のハードルが残っています。

Nvidia Has Received More Than $500 Billion in Orders Through 2026 - The Information

- Nvidiaは2025年初頭から2026年末までに5,000億ドル超の受注を受けたと明らかにし、次世代チップBlackwellとRubinへの需要が非常に強いことを示しました。

- これは2023〜2025年のHopper世代の売上(アジア除く)の5倍超に相当し、Nvidia株価は5%上昇しました。

- Nokiaに10億ドルを投資し、NokiaがNvidiaのAI対応通信向けハードウェアを採用することで、通信とAIを同時処理する「ソフトウェア定義の無線×AIコンピュータ」を共同で推進しました。

- 米エネルギー省とOracleと共に、アルゴンヌ国立研究所でBlackwell 10万基規模を含む2台のAIシステムを構築する計画を発表しました。

- 9つの国立研究所や複数の量子計算企業が、AIチップと量子計算を接続するNvidiaの新技術を採用する方針を示しました。

- ジェン・スン・フアンCEOはワシントンD.C.の開発者会議で愛国的なメッセージを交え、政策当局との関係性を強調しました。

Why Anthropic and OpenAI Are Using Cognition’s Coding Test - The Information

- 各社は公開ベンチマークの「漏れ学習(データ混入)」を避けるため、内部ベンチマークでモデルを評価しています。

- Cognitionの「Junior Dev」は既存コードの改変能力と解決速度を重視し、実務に近い長尺・多ファイル対応を測定しています。

- 現状の主力ではClaude Sonnet 4.5がエージェント型コーディングで優勢とされますが、各社の差は縮小しています。

- OpenAI、Anthropic、xAIはリリース前にJunior Devで評価を依頼し、弱点フィードバック(長文脈の苦手など)を改善に活用しています。

- SWE-Bench偏重の最適化は実タスク改善につながりにくく、Junior Devは複数言語での課題を含めて汎用性を測っています。

- 内部ベンチマークは製品改善サイクルを加速し、競争優位を生みます(例:Runwayは物理的に自然な動画生成の内部評価を運用)。

- CognitionのDevinは自社モデルに加え他社モデルも併用し、エコシステム型の最適構成で実力を引き出しています。

- 業界は「エージェント型コーディング」を進歩のバロメーターと見なしており、上位難度の「Senior Dev」も準備中です。

The Electric: This Startup Has Commercialized An Autonomous Electric Cropduster - The Information

- Pykaは固定翼の自律型電動散布機「Pelican Spray」を少量生産し、米国カンザスとブラジルの農場へ納入を進めました

- 2023年にFAAの承認を取得し、eVTOLより早く商用運用の道筋をつけました

- 散布機はレーダーとLiDARで超低空飛行や障害回避を自動化し、オペレーターは「旋回待機(loiter)」と「着陸」程度しか操作しない設計にしました

- 農業現場の実運用に合わせ、約15分ごとの離着陸や70ガロン薬液の補充、バッテリーのローテーションなどを前提に耐久性と運用性を最適化しました

- ハイブリッドの新機体「DropShip」を公開し、エンジン+バッテリーで約1,000マイルの航続を目指し、軍需の貨物輸送用途で大口需要を見込みました

- 2024年9月にシリーズBで約$40Mを調達し、累計$88M、時価総額約$94.7Mで生産拡大(翌年30機予定)を計画しました

- eVTOL各社が都市型旅客輸送の安全基準と認証で停滞する中、Pykaは既存設計に近い固定翼・無人・産業用途で早期実装を選びました

- 農薬散布は航空分野でも事故率が高く、無人化により安全性向上と均一散布の精度改善を同時に狙いました